Lukfi píše:no-X píše:Lukfi: ad efektivnost architektury...

O tom si popovídáme za rok, až se bude programovat plně pro SM3.0. Ale než takový hry přijdou, G7x i R5xx budou docela zastaralý. Jasně, pro ty co budou kupovat z bazaru budou Radeony X1K lepší volbou než GF6/7, ale kdo si koupil GF7800GTX někdy brzo po uvedení, rozhodně si nemůže stěžovat že by měl zastaralou architekturu. Ještě minimálně rok bude ta karta držet krok s RX1800XL/XT 256MB nebo RX1900GT/GTO.

Krátká paměť. Podívej se na

původní recenzi GeForce FX na PCT. A jak dopadla? Při uvedení karty nikdo FX nepovažoval za technologický propadák, zdála se ke všemu rychlejší než R9700. Stačilo půl roku a situace se obrátila o 180°. Když někdo tvrdil, že je FX technologicky pozadu, okamžitě byl nazván fanATikem a umlácen nicneříkajícími marketingovými pojmy jako SM2.0+ (R9700 měla

jenom SM2.0), CineFX, UltraShadow (to ATi taky neměla

). A přestože se historie opakuje, tak znovu bude nějakou dobu trvat, než lidem dojde, že čipy nVidie posledních několika generací nejsou stavěné s ohledem na budoucí hry, ale jsou navržené tak, aby dávaly výkon ve stávajících (tedy už dávno vydaných) hrách.

Lukfi píše:Než budou opravdu takový hry, který plně využijou výhody R5xx, ty featury cos tu vyjmenoval jsou k ničemu, protože je nikdo nepoužívá tim pádem má G71 srovnatelnej výkon a přitom míň tranzistorů, a i když GF6/7 má větší propady při AA/AF, těch 106 mil. tranz. navíc prostě nevokecáš...

Já nic "nevokecávám"

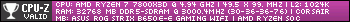

To je prostě technologická stránka čipu a ta je taká, jaká je. Tady máš graf propadu výkonu při anizotropní filtraci - GeForce 7800 (všechny optimalizace AF na default, ted zapnuté!) oproti X1800, na HQ-AF.

Radeon tedy v tomto testu používá plnou trilineární filtraci a úhlově neoptimalizované anizo, kdežto nVidia jen brilineární, případně bilinerání filtraci a úhlově optimalizované anizo... přesto má Radeon při kvalitnějším AF stále nižší propad výkonu.

Lukfi píše:Kvalitu obrazu posoudit nemůžu, ale spousta lidí ten rozdíl prostě nepozná.

Je dobře poznat i rozdíl na GF7, když si vypneš všechny "optimalizace" a třeba

takovejhle bilineární přechod mip-map byl normální někdy před deseti lety, kdy grafický čipy ještě neuměly trilineární filtraci.

Lukfi píše:btw jsem taky slyšel názor, že AA u nVidie je lepší, protože ATi vyhlazuje jen hrany, ale nVidia to kombinuje se supersamplingem, takže zlepšuje i kvalitu textur.

Velice by mě zajímalo od koho jsi ten názor slyšel

Protože v podobě, v jaký to tvrzení "servíruješ", sice zní hezky, nicméně není pravdivé. Režim 4x je u ATi i nVidie kvalitativně naprosto stejný, obojí je multisampling 4x, rotated-grid, gamma-corrected. Pouze s tím rozdílem, že ATi má mřížku pootočenou na jednu stranu, nVidia na druhou, ovšem směr pootočení nemá na výsledek vliv, kvalita vyhlazení hran se pouze zrcadlově otočí. ATi nabízí i režim 6x, který lze používat díky tomu, že umožňuje až trojnásobný loop-back, díky programovatelné mřížce dokáže všech 6 vzorků rozložit efektivně, podporuje vyšší barevnou/z-kompresi a paměťový řadič snese takový datový tok. Protože tohle všechno stojí nějaké tranzistory, se kterými ale nVidia šetří, tak aby vůbec mohla ATi nějak konkurovat, používá režim 8xS, což není nic jiného, než režim 4x, ale obraz je vykreslen v rozlišení vertikálně dvojnásobném a následně zmenšen. Je to tedy OGSS, konkrétně oversampling. Nejpomalejší, nejméně kvalitní a nejméně efektivní možnost. Když už někdo někdy používal supersampling, tak zásadně rotated grid, který má mnohem vyšší kvalitu (3Dfx, S3, ATi na CF) a ne ordered grid. Pokud se ptáš, proč nVidia používá neefektivní ordered gird, je to proto, že ho není třeba implementovat hardwarově a tudíž to nestojí žádné tranzistory. Že stojí za starou belu ví jen pár lidí, kteří grafice trošku rozumí. To je ale menšina, která nijak neovlivní prodeje - a ostatním to nevadí, protože tomu nerozumí. Abys zas neříkal, že to okecávám:

OGSS 2x:

RGSS 2x (od S3):

Při supersamplingu 2x z principu klesne výkon zhruba na polovinu. To je hodně vysoká daň. Jenže při OG je akceptovatelně vyhlazeno nějakých 20% z obrazu (viz první screenshot), kdežto při RG je vyhlazeno naopak cca 80% z obrazu (druhý screenshot). Jenže RGSS nelze v kombinaci s multi-samplingem bez HW podpory (=tranzistorů navíc) efektivně používat...

Takže už víme, že ordered-grid supersampling 2x má dvojnásobné nároky na fillrate (= poloviční výkon), má pozitivní efekt jen na cca pětinu obrazu a není pro jeho použití třeba HW implementace (tzn. může být provozován na libovolném grafickém čipu).

Pojďme dál. Supersampling ovlivňuje textury v tom směru, že na nich redukuje aliasing. Takže aby se projevil, musí na texturách nějaký aliasing být. Aliasing se na texturách může objevit tehdy, pokud dojde k minification, tzn. rastr textury má vůči rastru vykreslovaného obrazu vyšší rozlišení (zjednodušeně řečeno) a zároveň je použita nedostatečně kvalitní filtrace textur. Pokud ovšem použijeme kvalitní filtraci (např. ATi HQ-AF), snížíme pravděpodobnost výskytu aliasingu na textuře na minimum (prakticky se může objevit pouze tehdy, když hra nepoužívá korektní LOD). Není tedy lepší pořádně implementovat kvalitní filtraci textur, která nebude mít žádný dopad na výkon, než používat OG-supersampling, který srazí výkon na polovinu a zlepší kvalitu nějakých 20% úhlů?

GeForce 7 je rychlá karta, ale nesmí se po ní chtít technologie a kvalita obrazu - prostě je to jádro navržené s ohledem na minimální výrobní cenu, čemuž se muselo podřídit úplně vše a to podle mě není dobře.